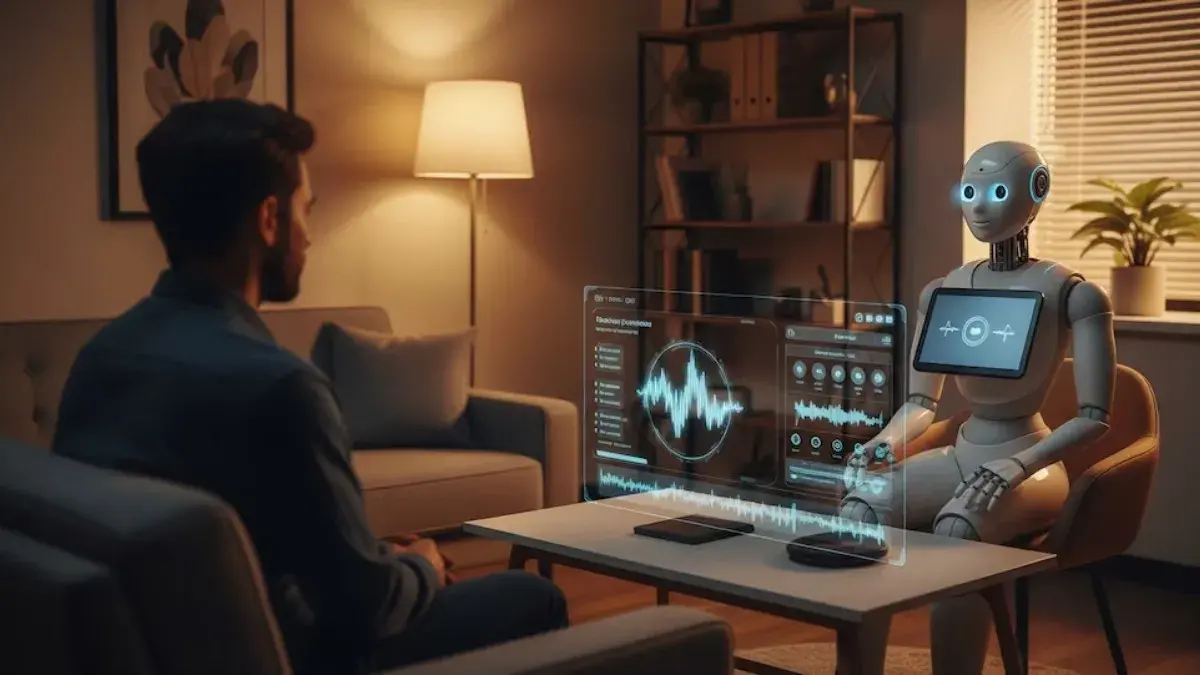

Advierten fuertes fallas al usar IA como psicólogo: sesgos, falsa empatía y riesgo para la salud mental

Una investigación de la Universidad de Brown encendió una señal de alerta sobre el uso de herramientas de Inteligencia Artificial como reemplazo de la terapia humana. El estudio reveló que los modelos actuales presentan fallas graves en áreas esenciales de la práctica clínica y que, lejos de ser un apoyo seguro, pueden ofrecer respuestas equivocadas o dañinas.

¡Mantenete al tanto de las últimas noticias de San Nicolás y el país!

Unite a nuestro CANAL DE WHATSAPP y recibí las novedades directamente en tu teléfono.

📲 Click AQUÍ Los especialistas señalaron problemas en cinco categorías críticas: respuestas sin considerar el contexto personal, vínculos terapéuticos deficientes, expresiones de empatía que no reflejan una comprensión real, sesgos culturales y religiosos, y fallas al abordar posibles situaciones de riesgo emocional. Para los investigadores, estos errores marcan una distancia insalvable con el trabajo de un profesional formado.

El análisis se centró en cómo responden los chatbots a pedidos habituales de usuarios que buscan contención, como replantear pensamientos o manejar emociones. Detectaron que los modelos imitan el lenguaje terapéutico pero no aplican técnicas reales, porque no pueden interpretar en profundidad lo que experimenta cada persona ni sostener intervenciones clínicas genuinas.

Otro punto clave es la falta de regulación. Mientras psicólogos y psiquiatras están sujetos a marcos éticos y supervisiones, las herramientas digitales operan sin controles ni responsabilidades claras, dejando a los usuarios expuestos y sin garantías frente a errores o respuestas inadecuadas.

El equipo también advirtió que la disponibilidad masiva de estos sistemas genera una falsa sensación de seguridad. Muchos modelos se lanzan sin evaluaciones rigurosas sobre su uso en áreas sensibles como la salud mental, lo que agrava los riesgos.

La investigación propone algunas pautas para quienes interactúen con IA como apoyo emocional: evaluar si las respuestas se ajustan a la situación personal, observar si el sistema promueve autonomía y pensamiento crítico, y verificar la sensibilidad cultural. También destacan que cualquier herramienta debería ser capaz de detectar señales de crisis y orientar hacia servicios profesionales.

Los autores aclararon que su objetivo no es descartar el potencial de la IA, sino remarcar que hoy no puede reemplazar la intervención humana. Por eso consideran urgente desarrollar marcos éticos, controles y mecanismos de supervisión antes de que estas tecnologías se consoliden como alternativas dentro del campo emocional.

LEER: Efemérides del 14 de febrero: nacimientos, hitos culturales y el Día de los Enamorados